Los acontecimientos recientes han demostrado que la rama de investigación de inteligencia artificial (IA) de Microsoft fue víctima de una grave violación de divulgación de datos. Una configuración incorrecta de una cuenta de almacenamiento de Azure provocó la divulgación de 38 gigabytes de datos internos confidenciales de Microsoft, según descubrió un grupo de ciberseguridad conocido como Wiz.

Cuando los investigadores de Microsoft compartieron datos de entrenamiento de IA de código abierto en GitHub, fue cuando ocurrió la violación de datos. Los usuarios recibieron una URL para recuperar los datos de una cuenta de almacenamiento de Azure, que ellos mismos proporcionaron. Sin embargo, el token de acceso que se envió dentro del repositorio de GitHub incluía un conjunto de permisos excesivamente amplio. Otorgó acceso de lectura y escritura a toda la cuenta de almacenamiento, no solo a los datos a los que se suponía que se debía acceder.

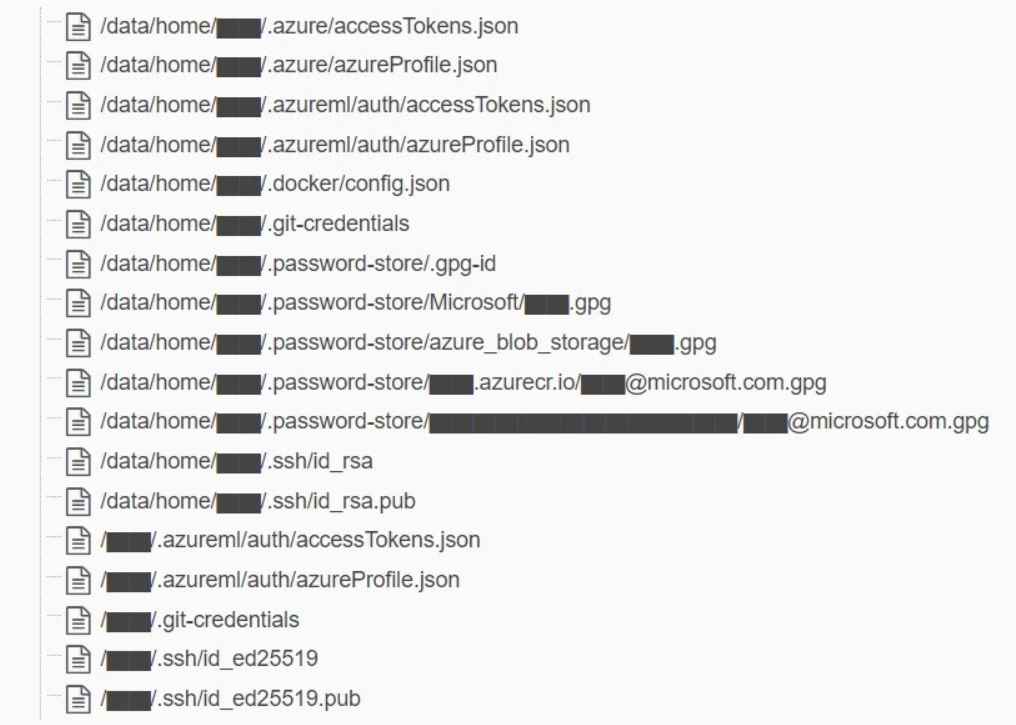

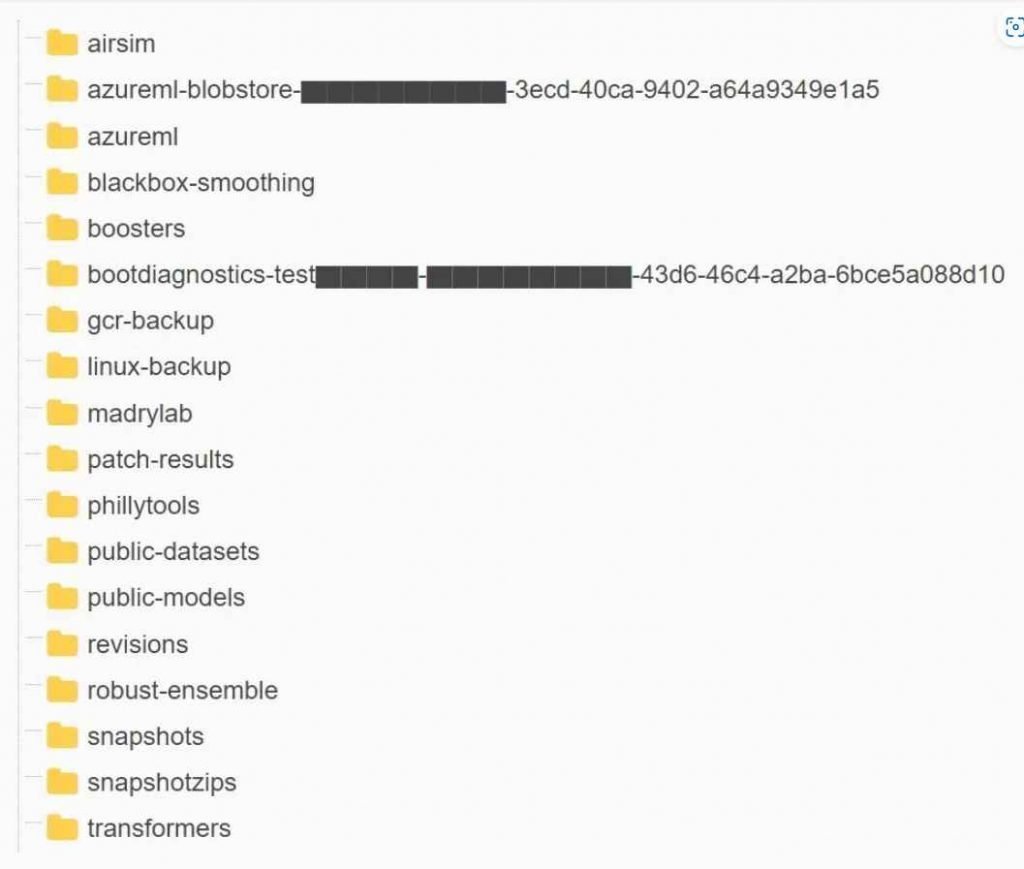

Wiz descubrió que esta cuenta incluía 38 terabytes de datos confidenciales de Microsoft, que incluían lo siguiente:

Copias de seguridad de las máquinas utilizadas por los empleados, que pueden incluir contraseñas, claves secretas y comunicaciones internas enviadas a través de Microsoft Teams.

Más de 30.000 comunicaciones privadas enviadas por 359 trabajadores de Microsoft utilizando la plataforma Microsoft Teams. El problema subyacente era que los tokens de Azure Shared Access Signature (SAS) se estaban utilizando sin los permisos adecuados. El acceso a las cuentas de almacenamiento de Azure se puede controlar de forma más detallada mediante tokens SAS. Por otro lado, si la configuración no se realiza correctamente, es posible que proporcionen un número excesivo de permisos. Un token de firma de acceso compartido (SAS) en Azure se describe como una URL firmada que proporciona acceso a los datos de Azure Storage por parte del equipo de Wiz. Esta información se puede encontrar en el sitio web de Azure. El usuario podrá modificar el nivel de acceso a su gusto; los permisos pueden variar desde solo lectura hasta control total, y el alcance puede ser un único archivo, un contenedor o toda la cuenta de almacenamiento.

Además, el usuario tiene control total sobre el tiempo de vencimiento, lo que le brinda la capacidad de generar tokens de acceso que nunca caducan.

En lugar de proporcionar acceso de solo lectura a la cuenta de almacenamiento, el token en este caso otorgó control completo del contenido de la cuenta. Además, no había fecha de vencimiento, lo que significaba que el acceso se otorgaría para siempre. Como resultado de una deficiencia en el monitoreo y control, los tokens SAS representan una amenaza potencial para la seguridad de los datos; por lo tanto, su uso debe restringirse en la mayor medida posible. Debido a que Microsoft no proporciona un método centralizado para manejar estos tokens dentro de la interfaz de Azure, realizar un seguimiento de ellos puede ser una tarea extremadamente difícil. Además, la duración de estos tokens se puede personalizar para que prácticamente duren para siempre, y no existe una edad máxima en la que se pueden utilizar. En consecuencia, no es una práctica segura utilizar tokens de Account SAS para compartirlos externamente. y los usuarios deben abstenerse de hacerlo. – Además, dijo el equipo de investigación de Wiz.

Debido a que existe una falta de control, Wiz sugiere imponer restricciones sobre cómo se pueden usar los tokens SAS a nivel de cuenta. Además, se deben utilizar cuentas de almacenamiento separadas para todos y cada uno de los motivos que impliquen el uso compartido externo. También se recomienda realizar un seguimiento adecuado y evaluaciones de seguridad de los datos compartidos.

Desde entonces, Microsoft invalidó el token SAS expuesto y realizó una evaluación interna del daño que pudiera tener. Además, se puede encontrar un reconocimiento del suceso en una publicación de blog reciente escrita por la corporación.

Debido a que cada vez más ingenieros de una organización trabajan con enormes volúmenes de datos de capacitación, esta historia ilustra los peligros adicionales que enfrentan las empresas cuando comienzan a utilizar la capacidad de la inteligencia artificial de manera más general. Los enormes volúmenes de datos con los que trabajan los científicos e ingenieros de datos necesitan controles de seguridad y precauciones adicionales mientras trabajan para poner en producción soluciones innovadoras de IA lo más rápido posible.

El cargo IA de Microsoft Azure filtra 38 GB de datos confidenciales, incluida la copia del disco de los empleados apareció primero en Noticias de seguridad informática, ciberseguridad y hacking.

Ver Fuente

No hay comentarios.:

Publicar un comentario